- 云擎技术

- 地址:广州市天河区燕岭路120号823

- 电话:020-38815864

- 邮箱:cs@cs003.vip

- 网址:http://www.cs003.vip

关注我们

关注微信订阅号

关注微信订阅号

关注微信订阅号

关注微信订阅号

- 友情链接:

- 工信部 |

- 公安备案 |

- 华南IDC圈-燕岭会 机房收录 |

- 众英达赏聘 |

- 企业热榜

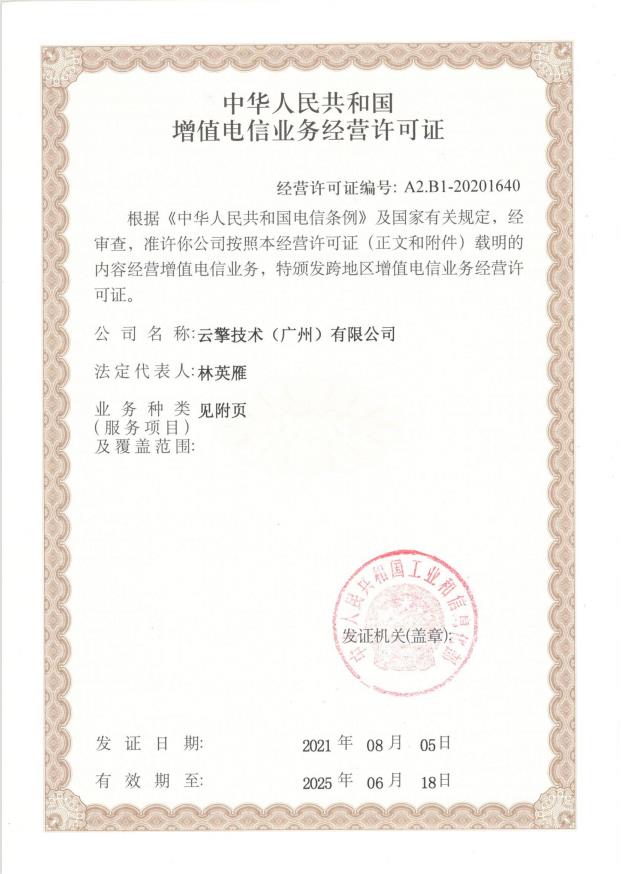

Copyright 2019,云擎技术 ALL Rights Reserved 增值电信经营许可证:A2.B1-20252753 备案号:粤ICP备2021145239号

- 返回顶部

- 020-38815864

- 微信咨询

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)